Netflix, l’entreprise américaine créée en 1997 se concentrait initialement sur la location et l’achat de DVD livrés à domicile. Cependant, en 2007, Netflix a lancé son service de vidéo à la demande par abonnement et depuis lors, elle s’est développée pour distribuer un grand nombre de films et de séries. Avec une grande quantité de données générées par les activités des utilisateurs, les recommandations de contenu et les analyses, Netflix commençait à peiner à gérer ses données.

Le développement d’Iceberg a été lancé par Ryan Blue et Dan Weeks en 2017. Le projet a été donné à la fondation Apache en novembre 2018. En mai 2020, le projet Iceberg est devenu un “top-level project” Apache.

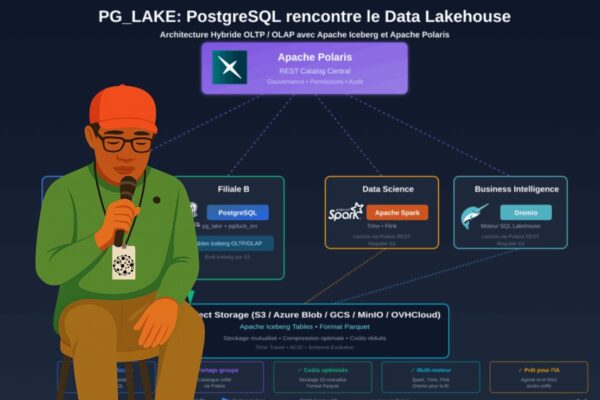

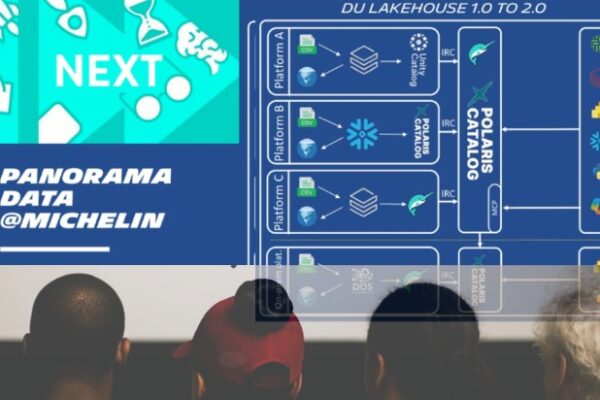

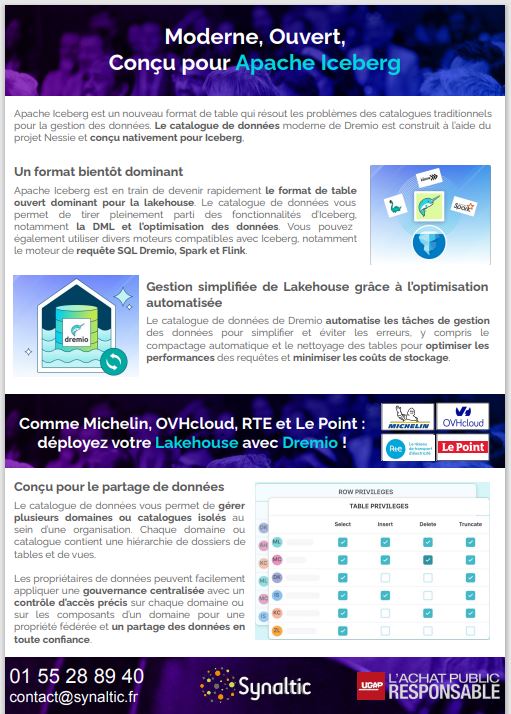

Depuis, Apache iceberg a été adopté par d’autres entreprises telles que Airbnb, Apple, Expedia, LinkedIn, Adobe, Le Point, La Poste, Michelin, Bic … Courant 2024, la spécification Iceberg est massivement adoptée par les éditeurs logiciels eux-mêmes, notamment Snowflake et Databricks.