Qu’est-ce qu’un Data Lakehouse ?

Des structures et des fonctions de gestion des données similaires à celles d’un data warehouse directement implémentées dans un stockage à faible coût de type data lake.

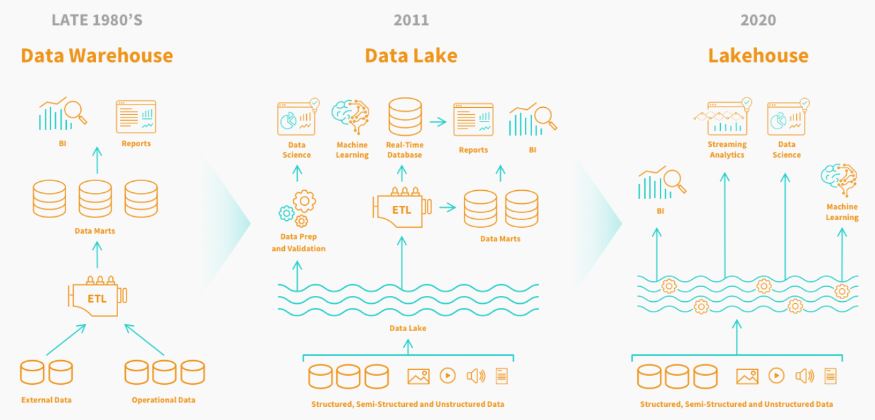

A l’origine : l’entrepôt de données.

Pour stocker et gérer les données, nous avons traditionnellement mis en place des entrepôts de données (ou data warehouse). Le principe de collecter la donnée, de l’enrichir par association, nettoyage ou calcul, et d’en assurer la cohérence. Pour supporter ces fonctionnalités, plusieurs solutions ETL (extract, transform, load) ont vues le jour … et dominent aujourd’hui le marché. Les données sont ensuite interrogées par les utilisateurs métier qui utilisent les données préparées dans les outils BI pour les rapports et les projections. Ces plateformes sont ainsi conçues pour supporter la prise de décision et effectuer des analyses sur de grandes quantités de données structurées. Voilà pour la définition d’un Data Lakehouse !Dans cette vidéo extraite du webinaire De la Business Intelligence aux décisions en streaming, Charly revient sur les 2 grands livres qui l’ont initiés au Data Warehousing.

Que deviennent les entrepôts de données aujourd’hui ?

Ces dernières années, les types, les sources ainsi que le volume de données ont explosés ! Maintenir un entrepôt est devenu complexe, cher et lent. Les limites de ces plateformes ne se présentent pas que du coté IT, les utilisateurs métier sont de plus en plus touchés. L’accès aux données devient parfois une peine, la vitesse n’est pas au rendez-vous et les évolutions ne sont pas toujours délivrées dans les temps. De plus les projets de data science et de machine learning réclament une connexion à la source des données, ce qu’un entrepôt de donnée n’a pas prévu. Si la technologie est remise en question, la méthodologie du data warehousing reste elle bien confirmée. Les bonnes pratiques de gouvernance sont désormais reconnues et ne demandent qu’à être complétées, par exemple avec les Data Contracts.Que nous apportent les lacs de données ?

Dès les années 2000, les lacs de données ont gagné en popularité en réponse aux limites des entrepôts de données traditionnels. Hadoop, avec son système de fichiers distribués (HDFS), a permis aux entreprises de stocker et de traiter de grands volumes de données de manière évolutive. Des plateformes comme Databricks et Dremio ont réalisées la convergence des lacs de données et des entrepôts de données. Databricks, Netflix et Uber ont introduit Delta Lake, Apache Iceberg et Apache Hudi, des formats de table qui ont introduit les transactions ACID dans les lacs de données. Depuis 2011, les lacs de données sont considérées comme des architectures peu onéreuses utilisées pour stocker les grandes quantités de données non structurées et semi-structurées qu’ils collectent et conservent dans des formats de fichier génériques et ouverts. Les données sont ajoutées au lac de données telles quelles, autrement dit sans association, calcul ou reformatage des nouvelles données. Ces fonctionnalités, bien présentes dans les entrepôts de données, reposent ici uniquement sur la cohérence des sources des données. Difficile donc de répondre aux exigences de qualité des données et de gouvernance ! Si les lacs de données ont séduit ceux qui cherchaient à réduire leur coût, il leur manque toutefois des fonctionnalités des data warehouses, comme la prise en charge des transactions et l’application de règles de qualité des données.

Data Warehouse, Data Lake, Data Lakehouse : comparaison

Le Data Lakehouse, une combinaison du meilleur des deux mondes !

Un Data Warehouse facilite la prise de décision et permet la gouvernance de données. Cependant des problèmes de volumétries, de vitesses, de coûts et d’accès aux données apparaissent. Un Data Lake résout ces problèmes cependant nous perdons la gouvernance des données.

Un Data Lakehouse est la solution ! Des structures et des fonctions de gestion des données similaires à celles d’un entrepôt de données sont directement implémentées dans un stockage à faible coût de type lac de données. Utilisant des formats ouverts et universels, Dremio se présente alors comme un Open Data Lakehouse.

Data Lakehouse : Architecture, Avantages, Limites et Défis

Pour aller plus loin :

[…] En anglais le mot utilisé est “Literacy” ! Ici, elle désigne l’aptitude à lire, à comprendre, à utiliser, ici les données, dans le cadre de ses activités professionnelles. C’est donc la capacité d’identifier, de collecter, de traiter, d’analyser et d’interpréter des données […] Toutes les organisations sont désormais contraintes de construire une “culture des données” pour rester compétitives.

L’architecture ouverte du Data Lakehouse vous permet de garder un réel contrôle de leurs données, et soutient l’autonomisation des utilisateurs dans l’appropriation des données pour prendre des décisions quotidiennes. Les processus métier modernes sont de plus en plus conçus pour l’analytique ; par conséquent, les bases de données sont transférées dans le lac de données, via Debezium, Apache Kafka et Apache Iceberg, pour être consolidées et interrogées via Dremio.

Notre choix : Dremio

En terme de Data Lakehouse, nous recommandons depuis 2018 la solution Dremio.

Dremio fournit un moteur de requête et d’accélération basé sur Apache Arrow et offre la possibilité de créer une couche libre-service pour les scientifiques et les analystes. Synaltic est partenaire Dremio depuis 2021 et nous sommes ainsi le premier intégrateur en France de l’Open Data Lakehouse Dremio !

Organiser une démonstration

*champs obligatoires