Il y a des jalons techniques qui passent inaperçus, et puis il y en a d'autres qui méritent qu'on s'arrête. La graduation d'Apache Polaris en Top-Level Project (TLP) à la... Lire la suite →

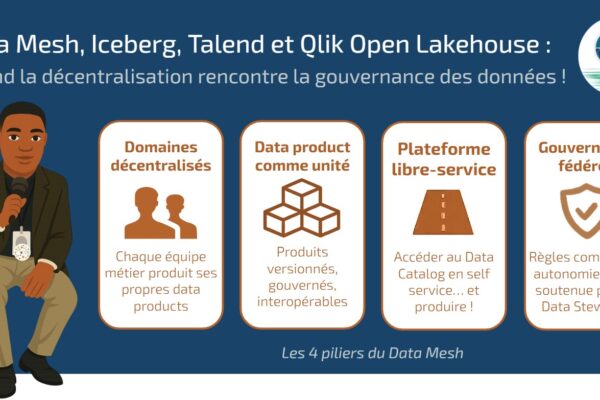

Les entreprises collectent et produisent de plus en plus de données. Pourtant, la majorité d’entre elles peinent à les exploiter pleinement : silos organisationnels, goulots d’étranglement dans les équipes IT,... Lire la suite →

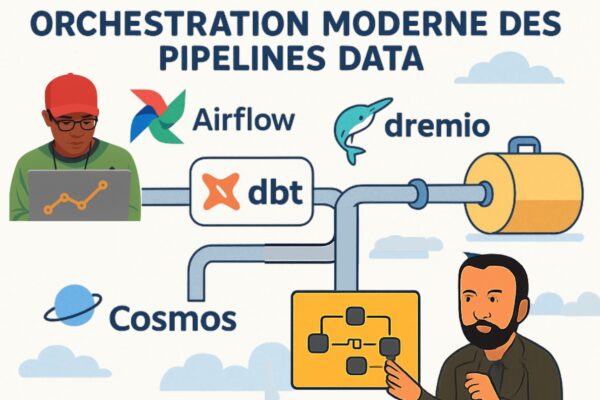

Orchestration Moderne des Pipelines Data avec Airflow, DBT, Dremio et Cosmos. Vous trouverez plusieurs articles sur notre site qui présentent DBT, le framework ETL que nous utilisons pour construire les... Lire la suite →

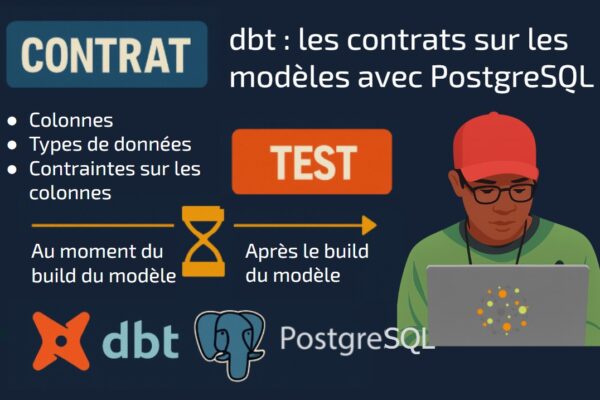

Un contrat sur un modèle est une fonctionnalité qui aide dans la gouvernance des données. Il permet de garantir la cohérence et la fiabilité de vos modèles dbt. Les personnes... Lire la suite →

Apache Airflow® est un orchestrateur de workflows puissant, basé sur la planification de DAGs (Directed Acyclic Graphs). Par défaut, les DAGs sont planifiés à l’aide d’expressions cron classiques ou d’objets... Lire la suite →

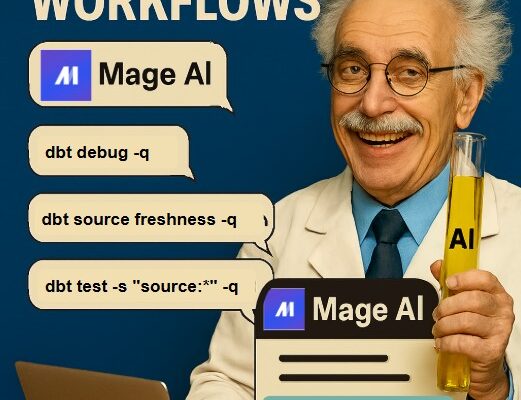

Si vous utilisez dbt Core, vous vous êtes sûrement déjà posé la question : “comment orchestrer les commandes que je tape à la main 🤔?” Que ce soit pour vérifier... Lire la suite →

Actuellement, Apache Superset™ n’offre pas la possibilité d’avoir des titres dynamiques dans un tableau de bord. Lorsqu’on ajoute un en-tête (header), on écrit le texte qu’on veut voir affiché de... Lire la suite →

Nous avons parcouru un long chemin ensemble : le paradoxe français face à Kubernetes, l'architecture révolutionnaire, le ROI convaincant, et l'implémentation concrète d'une stack lakehouse complète. Il est temps de... Lire la suite →

Nous avons exploré le paradoxe français, l'architecture révolutionnaire, et le ROI convaincant. Passons maintenant à la pratique : comment déployer concrètement une stack lakehouse moderne sur Kubernetes ? Cet épisode... Lire la suite →