Dernier volet de la série « Charly Clairmont au Hadoop Summit » ! Après presque une semaine à San José, notre CTO conclue son périple en dressant un bilan de la conférence annuelle dédiée aux technologies du big data.

Pour lire les épisodes précédents :

Le Hadoop Summit 2016 se termine et nous nous posons tous la même question : « Avons-nous réellement été surpris, enthousiasmés par un projet ou une solution ? » ! Et la première réponse qui nous vient à l’esprit est : non ! On est loin de cette émotion que nous avait, par exemple, provoquée Spark en 2012…

OK, on ne peut pas avoir un Spark tous les ans ou tous les deux ans ! L’ensemble des conférences étaient quand même de bon niveau, mais il nous manque ce petit truc qui fait que l’on en garde un meilleur goût !

Bien entendu, le marchine learning a eu toute sa place durant la conférence et cela laisse présager qu’il va s’étendre dans les années avenir. Il m’a même été annoncé que l’intelligence artificielle va avoir sa propre conférence. Oui ! Mais hélas, nos entreprises françaises n’en sont pas là. Elles n’ont même pas encore toutes compris comment tirer leur épingle du jeu avec Hadoop !

Quelques belles annonces tout de même

Après mures réflexions je peux tout de même citer des projets ou initiatives qui vont continuer à prendre tout leur sens :

- Apache Beam : Oui, il faut unifier toutes les approches de batch, de streaming… même Storm que l’on croyait mort va s’y mettre. C’est Google qui va être content…

- CDAP (Cask Data Application Platform) : C’est mon chouchou ! Contrairement à ce que les gens peuvent penser, Hadoop n’est pas qu’une plateforme où l’on fait de l’ETL et des requêtes SQL sur HIVE ! C’est un plateforme omni-cas-d’utilisations ! On sait tout y faire. Et donc, on sait y bâtir des applications, des applications qui savent traiter la donnée à l’échelle. Ce qu’il faut retenir c’est que nous reproduisons forcément les meilleures pratiques qui nous ont été enseignées. Si bien qu’une application, appelons la « Big Data », aura les mêmes composants qu’une application, que l’on qualifiera de traditionnelle ! Aujourd’hui les API sont certainement de trop bas niveau pour attirer les développeurs et permettre aux entreprises de bien en tirer partie. Il faut les couches d’abstractions nécessaires et les outils pour déployer et exploiter ces applications d’un nouveau genre. Et pour ça il y a Cask ! Personne n’est aujourd’hui à un tel niveau.

- Les Assemblies : Quand Apache Slider a été initié, de nombreuses personnes ont du se demander à quoi servait ce machin là ! Ou encore se dire qu’on avait déjà Mesos pour ça ! De toutes les façons YARN n’a été pensé que pour faire tourner des jobs batch pour Hadoop. Même si tout comme Mesos, YARN est un système d’exploitation pour data center ! Hé Hé ! Et bien en 2016, c’est plus clair pour tout le monde ! Les assemblies vont devenir une manière de livrer des applications qui intégreront tout ou partie des composants de l’écosystème Hadoop, montées en architecture distribuée… Et elles sauront passer à l’échelle. Prenons le nouveau projet Apache Metron dont le but est de surveiller les réseaux. Il est bâti avec des composants de l’écosystème Hadoop. Et bien c’est une application… Pas la peine de la re-développer pour un client, non ? Il va suffire d’en instancier l’assembly ! Et c’est là que rentre en jeux Docker et que SequenceIQ, qu’avait racheté Hortonworks, joue pleinement son rôle. Vous savez les gars qui faisaient de l’Hadoop et du Docker ? Les Assemblies vont considérablement changer la donne.

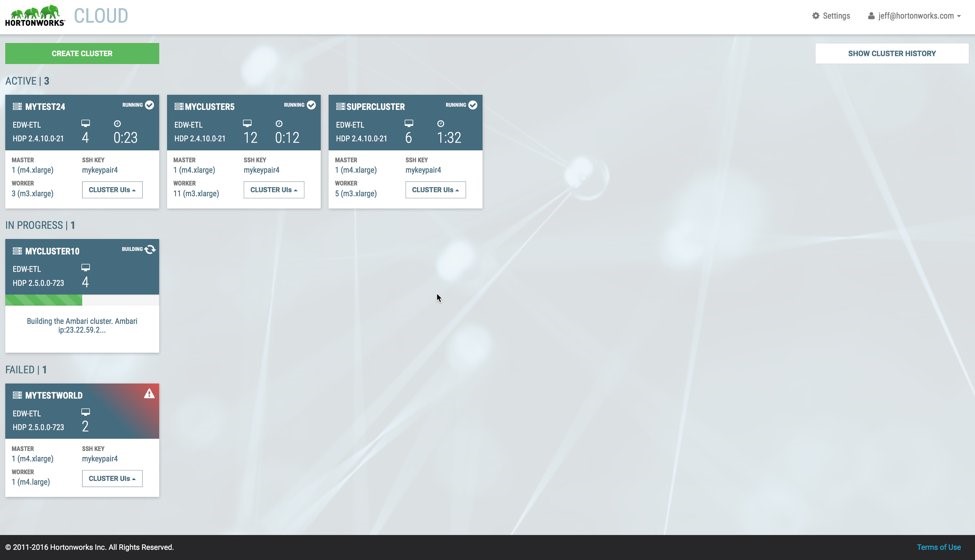

Hortonworks en pleine mutation

Hortonworks est en pleine mutation. L’éditeur, qui s’est longtemps concentré sur le bas niveau, est en train, doucement mais sûrement, d’élargir sa capacité à générer des profits. Il se lance carrément dans les applications finales – c’est le cas avec Metron. Il s’aventure dans le cloud et bouge ses pions sur la Business Intelligence avec Zeppelin ! Sans oublier Nifi qui laisserait penser que cette solution de transport des données pourrait pousser le bouchon jusqu’à l’ETL ! Et là on voit bien qu’Hortonworks ne se voit plus en simple grand défenseur d’Hadoop !

A tel point que, contrairement à ce que je disait hier en conclusion de mon billet, 2016 vivait le dernier Hadoop Summit ! Sérieusement, désormais le rendez-vous s’appellera Dataworks Summit !

Looking forward to seeing you next year, as DATAWORKS SUMMIT

— DataWorksSummit (@DataWorksSummit) June 30, 2016

Si l’on peut être ravi qu’Hortonworks trouve sa voie, on pourra peut-être s’inquiéter de l’absence d’événement entièrement dédié à Hadoop. Hadoop est devenu une commodité ! Ce n’est pas encore le cas partout ! Mais c’est la fin d’un cycle : 10 ans…

A en croire Hortonworks, les 10 prochaines années, nous les passerons moins dans la plomberie pour mieux nous concentrer sur les besoins réels des clients.

Une chose est sûre, le marché est en train de changer : Cloud, très grosses machines pour faire tourner Hadoop… Il sera temps de choisir les bons équilibres pour bien tirer partie d’Hadoop.

Sections commentaires non disponible.