Envoyé spécial au Berlin Buzzword 2017, Charly Clairmont poursuit son exploration des dernières tendances de l’open source. Aujourd’hui, il nous parle de data au service de l’humanité et des dernières innovations autour d’Apache Kafka.

L’expérience du Berlin Buzzword est vraiment passionnante. Une large place est donnée à la communauté open source et les talks sont souvent captivants.

Si vous avez suivi mes tweets vous avez dû noter une certaine effervescence ! Enfin peut-être pas non plus, il ne faut pas exagérer ! Toutefois, j’ai eu de nombreuses réponses, retweets. Ce que je racontais devait un peu intéresser… Bref !

La journée avait bien commencé avec Duncan Ross, de Data Kind, une organisation à but non lucratif, qui œuvre à exploiter les données au service de l’humanité. Ross a réalisé un sondage pour savoir à quel point nous craignions ou non l’intelligence artificielle. Il suggérait à quel point encadrer l’IA était très difficile, voire subjectif se rapprochant du proverbe « le bonheur des uns fait le malheur des autres« . En effet, l’algorithme qui fait économiser à l’un peut entraîner une diminution de revenu pour l’autre (voir l’article « Sexist algorithms« ). Ici, Il est surtout question de découpler les propositions de l’algorithme des décisions à prendre (voir l’article « Fair data – fair algorithm ?« ). Un algorithme pouvant aussi être biaisé par les données qui lui ont été fournies, sans même parler de leurs qualités. Bref comme hier, Duncan Ross nous a remis une petite couche sur notre responsabilité en tant qu’informaticiens/nes.

Il a aussi été question d’engagement pour prendre part au débat citoyen et expliquer largement au plus grand nombre l’impact du numérique au sein de notre monde.

Avec une telle introduction, nous voilà gonflés à bloc pour suivre les différentes sessions plus techniques !

Streaming, LE buzzword du Buzzword !

J’en reviens à mes tweets ! Durant la session sur Apache Kafka Stream mon téléphone n’a pas arrêté de vibrer : plusieurs membres de l’équipe de Confluent ont apprécié un de mes tweets et c’est allé jusqu’à Jay Kreps, co-créateur de Apache Kafka. Une chose est sûre, la salle était pleine à craquer !

Packed room for @apachekafka stream presentation done by @miguno #bbuzz pic.twitter.com/F5GuCHxQ8B

— Charly CLAIRMONT (@egwada) 13 juin 2017

Tout le monde était là pour voir diffuser la vision de Ben Stopford, de Confluent, qui voit en Apache Kafka La Plateforme de Données par excellence : tous les traitements peuvent y être exécutés depuis l’arrivée de Kafka St-Jean et Kafka Connecté ! Michael G. Noll a fait une très vive et passionnée présentation d’Apache Kafka Stream plaçant d’emblée Apache Kafka comme chantre du système d’information des organisations.

Le transport des données s’architecture désormais très souvent avec Apache Kafka, toutefois les solutions d’ingestion ne manquent pas. Apache Nifi constitue une bonne solution, fiable pour collecter et à acheminer des données. MiniFi, version très légère, peut tourner sur des appareils faibles en ressources (IOT, Android, Raspbery…).

Si à Berlin Buzzword, il s’agissait d’une vulgarisation des concepts d’Apache Nifi, au Dataworks Summit, c’est HDF 3.0 qui tient la vedette ! Car, de l’autre côté de l’Atlantique, Hortonworks avait présenté une solution complète pour gérer le streaming de bout en bout ! Apache Nifi étant la brique d’acheminement alors qu’une nouvelle solution, Streaming Analytics, aide à la construction de traitement temps réel (Apache Storm). Bref « streaming » est définitivement le buzzword !

Les grands bluffent

Deux solutions m’ont bluffé dans lors de cette deuxième journée à Berlin Buzzword : Apache Apex et Hopswoks.

Apache Apex, je l’avais déjà évoqué suite au Hadoop Summit de 2016. Sauf que depuis, cette solution a gagné en élégance. Elle peut, à mon avis, aider réellement à quitter l’ETL classique pour tout réaliser en streaming : objectif réduire les durées de traitements.

Petit rappel de Thomas Wise, Apache Beam est une bonne initiative. Toutefois, ce cadre de développement oblige de s’inscrire dans les primitives de Beam, et non ceux du moteur d’exécution lui même. On risque ainsi de trop s’écarter de la richesse fonctionnelle du moteur d’exécution.

« Hadoop for Human« , C’est le slogan de Hops et de Hopswork. C’est une distribution Hadoop Européenne, tout doit sortie d’un projet de recherche suédois, financé en partie par l’Europe.

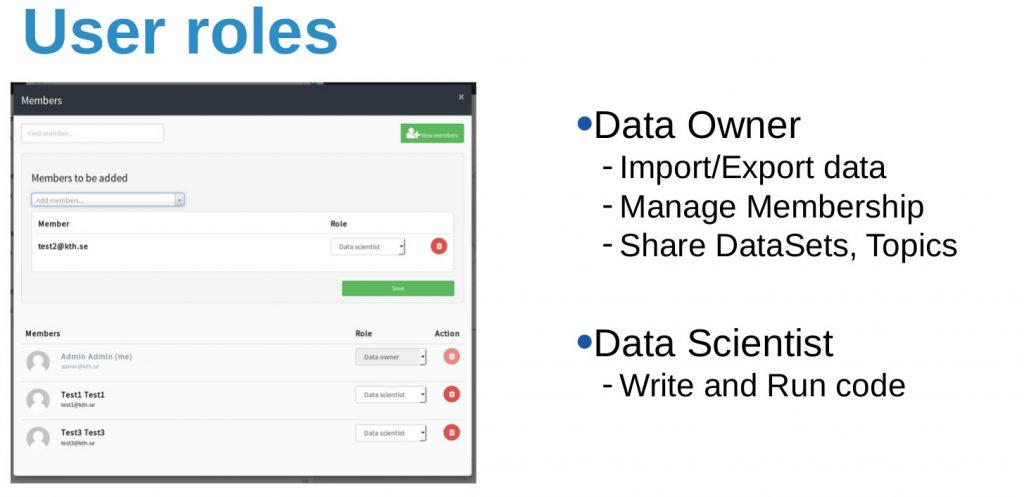

La présentation de Jim Dowling mérite d’être vue ! La plateforme est très usuelle. Elle est pensée pour assister et encadrer l’utilisateur (métier, développeurs, data scientiste, Ops…). Par exemple, la sécurité est gérée simplement et efficacement : pas de re-copie de données mais un partage efficient et sécurisé.

Pour finir j’ai participé au workshop de Mapr, où l’on à pu voir la gestion de bout en bout d’une chaîne IOT. Ce fut l’occasion de discuter avec Tugdual Grall et Ted Dunning.

Sections commentaires non disponible.